kang's study

8일차 : 확률적 경사 하강법 (Stochastic Gradient Descent) 본문

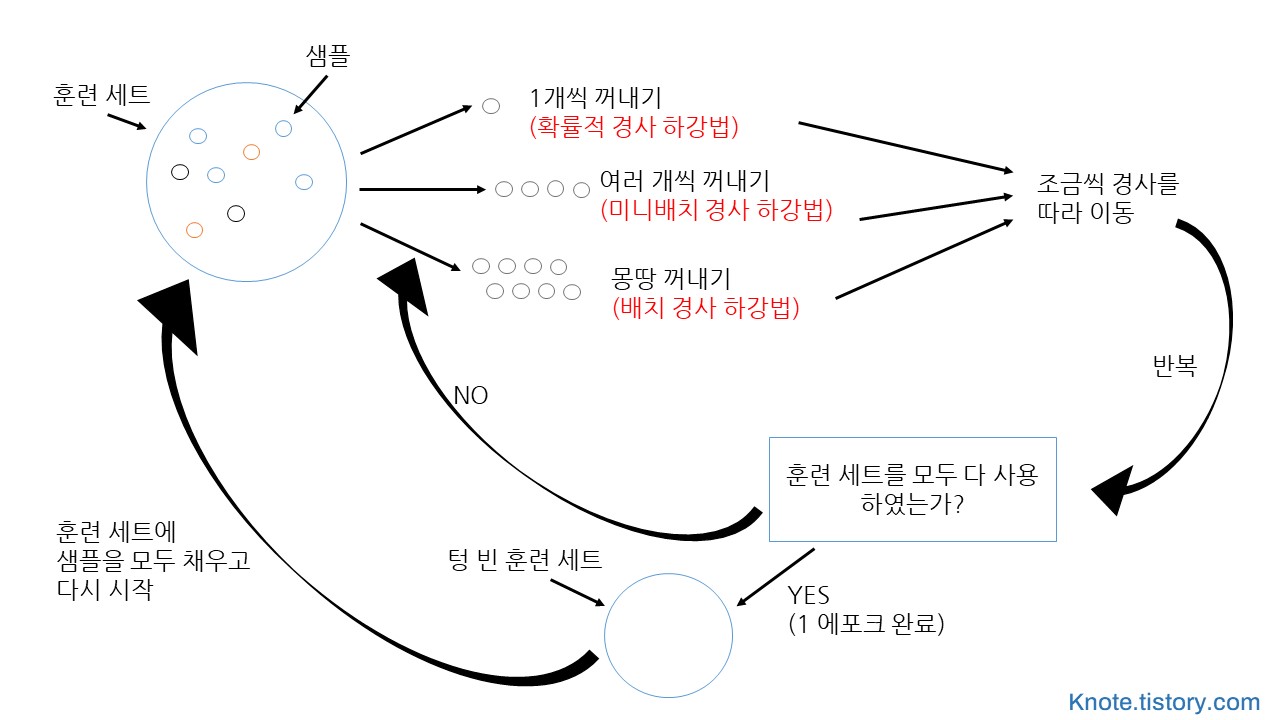

확률적 경사 하강법 (Stochastic Gradient Descent)

대표적인 점진적 학습 알고리즘

훈련데이터가 한 번에 준비되는 것이 아니라 조금씩 전달되는 경우

한번 학습할 때 랜덤하게 추출한 일부 데이터에 대해 가중치를 조절¶

점진적 학습 : 새로운 데이터가 들어와도 가중치와 절편을 유지하며 업데이트하는 최적화 방법¶

데이터 준비¶

In [1]:

import pandas as pd

fish = pd.read_csv('https://bit.ly/fish_csv_data')

In [2]:

fish_input = fish[['Weight','Length','Diagonal','Height','Width']].to_numpy()

fish_target = fish['Species'].to_numpy()

In [3]:

from sklearn.model_selection import train_test_split

train_input, test_input, train_target, test_target = train_test_split(

fish_input, fish_target, random_state=42)

In [4]:

from sklearn.preprocessing import StandardScaler

# 확률적경사하강을 위해서 반드시 필요한 과정

ss = StandardScaler()

ss.fit(train_input)

train_scaled = ss.transform(train_input)

test_scaled = ss.transform(test_input)

In [5]:

from sklearn.linear_model import SGDClassifier

# 확률적 경사 하강법을 제공하는 분류 모델

In [6]:

sc = SGDClassifier(loss='log', max_iter=10, random_state=42)

# 하이퍼파라미터 지정해야함, max_iter는 에포크

sc.fit(train_scaled, train_target)

print(sc.score(train_scaled, train_target))

print(sc.score(test_scaled, test_target))

In [7]:

sc.partial_fit(train_scaled, train_target) # 기존의 학습을 유지하면서 다시 학습

print(sc.score(train_scaled, train_target)) # 하나씩 샘플을 꺼내서 쓴다

print(sc.score(test_scaled, test_target)) # 사이킷런에는 확률적경사하강만 가능하다

에포크와 과대/과소적합¶

In [8]:

import numpy as np

sc = SGDClassifier(loss='log', random_state=42)

train_score = []

test_score = []

In [9]:

classes = np.unique(train_target)

for _ in range(0, 300):

sc.partial_fit(train_scaled, train_target, classes=classes)

# 훈련세이터의 일부분만 주어진다는 가정 때문에 전체 샘플의 클래스 목록을 전달해야주어야함

train_score.append(sc.score(train_scaled, train_target))

test_score.append(sc.score(test_scaled, test_target))

In [10]:

import matplotlib.pyplot as plt

plt.plot(train_score, "b")

plt.plot(test_score, "r")

plt.xlabel('epoch')

plt.ylabel('accuracy')

plt.show()

In [11]:

sc = SGDClassifier(loss='log', max_iter=100, tol=None, random_state=42)

sc.fit(train_scaled, train_target)

print(sc.score(train_scaled, train_target))

print(sc.score(test_scaled, test_target))

In [12]:

# 기본 손실함수: 힌지손실(hinge)은 SVM 알고리즘을 위한 손실함수이다.

sc = SGDClassifier(loss='hinge', max_iter=100, tol=None, random_state=42)

sc.fit(train_scaled, train_target)

print(sc.score(train_scaled, train_target))

print(sc.score(test_scaled, test_target))

출처 : 박해선, 『혼자공부하는머신러닝+딥러닝』, 한빛미디어(2021), p199-215

'[학습 공간] > [혼공머신러닝]' 카테고리의 다른 글

| 10일차 : 교차검증과 그리드 서치 (0) | 2022.03.03 |

|---|---|

| 9일차 : 결정트리 (Decision tree) (0) | 2022.03.03 |

| 7일차 : 로지스틱 회귀분석 (분류) (0) | 2022.03.03 |

| 6일차 ② : 다중회귀_규제 (0) | 2022.03.02 |

| 6일차 ② : 다중회귀_규제 (0) | 2022.03.02 |

Comments